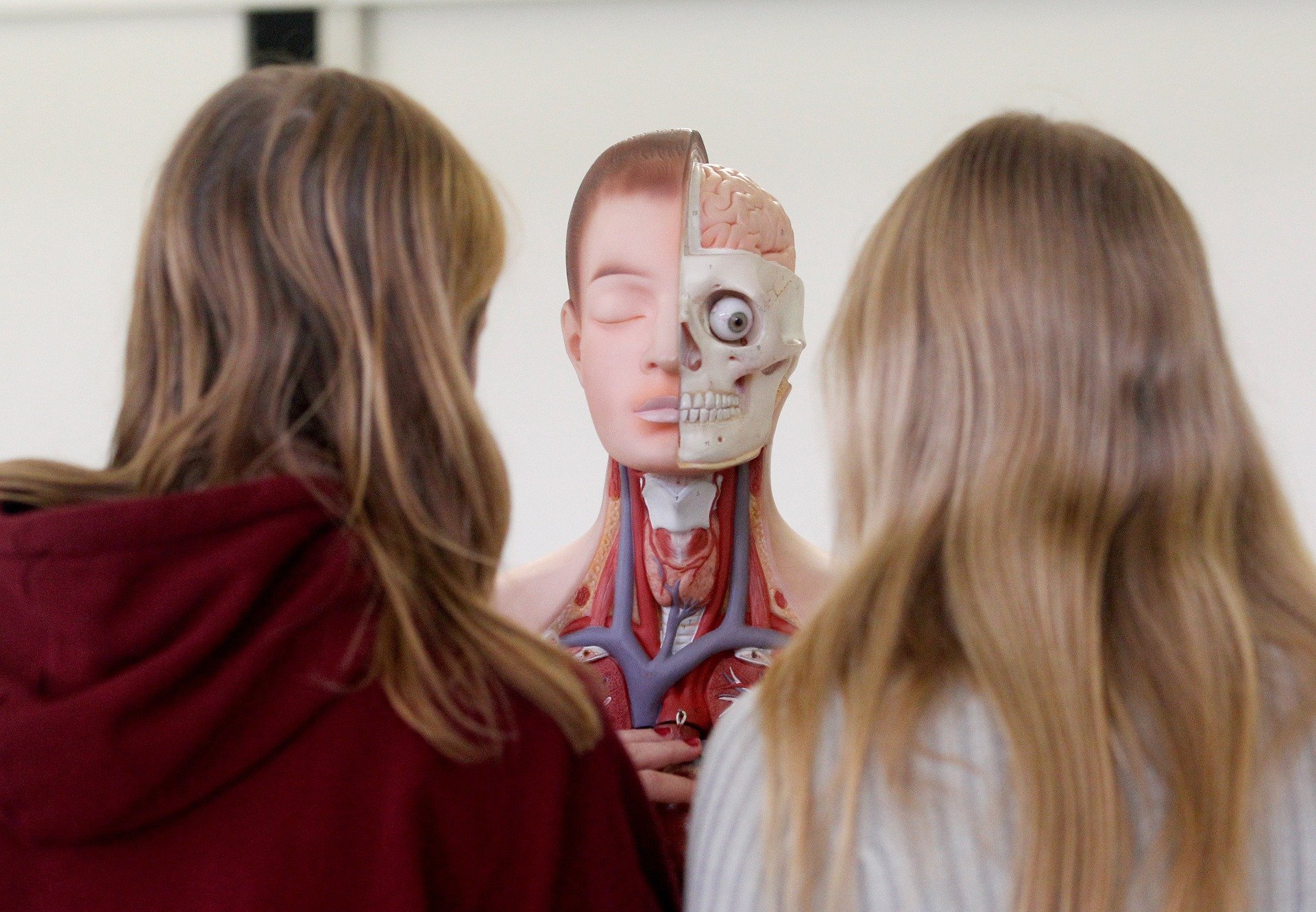

Научный фестиваль Science Fest в Санкт-Петербурге. Фото:Петр Ковалев /ТАСС

Словосочетание «искусственный интеллект» (ИИ/AI)* в течение всего лишь года перекочевало из лексикона профессионалов и любителей футурологии и фантастики в повседневный язык. Это уже третья по счету с появления самого понятия в 1956 году волна интереса к нему, и именно она оказалась более успешной, чем предыдущие, — прорыв для массового сознания случился только осенью 2022 года. Он связан с появлением ChatGPT, он дал возможность общаться посредством чата с ИИ как с человеком, прося выполнить те или иные интеллектуальные задачи. И получая весьма достойный результат, часто не уступающий тому, которого добился бы человек, решая поставленную ему задачу. В результате так называемый «тест Тьюринга» — сможете ли вы отличить по ответам на задаваемые вопросы человека и робота — оказался пройденным сам собой.

«ЧЕЛОВЕК ВЗАИМОДЕЙСТВУЕТ С ОДНИМ КОМПЬЮТЕРОМ И ОДНИМ ЧЕЛОВЕКОМ. НА ОСНОВАНИИ ОТВЕТОВ НА ВОПРОСЫ ОН ДОЛЖЕН ОПРЕДЕЛИТЬ, С КЕМ ОН РАЗГОВАРИВАЕТ: С ЧЕЛОВЕКОМ ИЛИ КОМПЬЮТЕРНОЙ ПРОГРАММОЙ. ЗАДАЧА КОМПЬЮТЕРНОЙ ПРОГРАММЫ — ВВЕСТИ ЧЕЛОВЕКА В ЗАБЛУЖДЕНИЕ, ЗАСТАВИВ СДЕЛАТЬ НЕВЕРНЫЙ ВЫБОР».

(Стандартная формулировка «теста Тьюринга» на основании статьи Алана Тьюринга «Вычислительные машины и разум» (журнал Mind, 1950 г.)

Резкая эскалация напряженности во всем мире несколько отвлекла на себя часть внимания, но это не помешало ChatGPT покорить мир: он установил рекорд по быстрому росту аудитории, достигнув 100 млн активных пользователей всего за два месяца после запуска. Такой оглушительный успех положил начало лихорадочной гонке технологических гигантов вроде Microsoft, Google, Baidu — да и включившихся в этот же процесс российских «Яндекса» и «Сбера», а также многих других.

«Очеловечивание» искусственного

Тем самым был преодолен очень четко работавший до этого принцип, сформулированный в формуле Ларри Теслера: «ИИ — это все, что не сделано до сих пор». Распознавание текста, игра в шахматы, перевод с разных языков, кредитный скоринг (проверка кредитоспособности) в банках или то, как устроена фотография в современных смартфонах, — это тоже проявления искусственного интеллекта как технологического направления… По мере прохождения «вау-эффекта» все это стало незаметной обыденностью. Люди все еще ощущают магию ИИ в автомобильном автопилоте, но полагают, что просто наследник паровоза стал более продвинутым. Но вот приобретение искусственным интеллектом антропоморфных черт в самом сокровенном, в том, что мы считаем имманентным человеку — разумном общении, построении логических выводов и обращении их в стройные тексты или изображения, — принципиально поменяли отношение к ИИ. Впервые

для человечества стало реальностью не просто выполнение искусственным интеллектом каких-то рутинных интеллектуальных операций типа распознавания или классификации, а по-человечески «разумное» поведение в форме поддержания беседы.

И кстати, иногда и так называемых «галлюцинаций», то есть выдачи в качестве совершенно уверенной истины некоторых несуществующих вещей, по сути, придуманных компьютером. Переход от чисто аналитической функции к генеративной стал водоразделом, за которым происходит «очеловечивание».

И уже перестало казаться несбыточной фантастикой появление сильного (он же универсальный) ИИ —гипотетического искусственного интеллекта, способного решать любые интеллектуальные задачи и самостоятельно осуществлять целеполагание, — то есть сравнимого с человеческим по своим свойствам, а во многих смыслах даже превосходящего его. Конечно, современные проявления ИИ в общем далеки еще от этого и имеют массу ограничений, но магия больших языковых моделей (это название технологии, которая и дала столь эффектный результат) для многих уменьшила дистанцию между людьми и машинами до слаборазличимой. А тут же естественным образом возникший хайп направил в отрасль столь огромные бюджеты, что это не может не ускорить прогресс. Интерес настолько велик, что даже в российской властной риторике вместе с призывами к возвращению к истокам и традициям соседствуют и декларации о том, что искусственный интеллект теперь наше всё и стратегическая область.

Фото: dpa / picture-alliance

Статистический попугай

Особенностью нынешнего пришествия ИИ (длящейся последнее десятилетие уже третьей большой волны, про которую все думали, что она вот-вот сдуется, как и предыдущие) стало то, что она базируется не на идее осознания людьми своих знаний и какой-то контролируемой формы «закладывания в машину», а на использовании концепции машинного обучения. То есть на появлении «интеллектуальных способностей» за счет обучения на каких-то предоставленных машине наборов данных, описывающих предметную область, а также реальный или синтетически предыдущий опыт.

Это довольно старая идея, которая идет еще из середины XX века. Но до определенного времени не было таких алгоритмов и вычислительных мощностей. А когда они появились, то началось лавинообразное распространение решений и их внедрение в жизнь. На сегодняшний день «венцом творения» стали так называемые большие языковые модели, которые способны обучиться на гигантском объеме информации, фактически охватывающем все знания мира. И благодаря им «статистический попугай», как некоторые называли искусственные нейронки из-за того, что свой результат они генерируют, предсказывая наиболее вероятное слово (или пиксель, если речь про изображения), наглядно продемонстрировал переход количества в качество.

При этом человек не обладает полным контролем над тем, что именно усвоил такой электронный мозг. Собственно, обучение такой искусственной нейронной сети очень похоже на то, каким образом обучается и человек. Мы знаем, что пока сеть находится в состоянии «мышления» в рамках того, что ей дано, но до конца не знаем, как именно. Зато можем контролировать то, что дается в качестве обучающих данных, и стараться избегать плохого, например, какой-то предвзятости. Хотя для реальных исторических данных это получается плохо, предвзятости в нашей реальной жизни полно. Например,

несколько лет назад был случай, когда нейросеть, которую пробовали научить раннему обнаружению преступников на основе анализа большого массива старых дел, оказалась… расистской.

То есть искусственная нейронная сеть, обученная на данных из прошлого, вполне может дать и воспроизведение отрицательных паттернов из этого прошлого. А искусственно созданные так называемые синтетические данные могут оказаться недостаточно соответствующими той реальности, в рамках которой придется принимать решение.

Еще одна важная вещь — чтобы скормить сети данные, надо сначала их собрать. Отсюда следует идея собирать как можно больше данных. И делать это с изрядным запасом — мы же не знаем, что пригодится. Но любые собранные данные сразу становятся источником рисков их утечки и использования во вред. Не говоря о том, что вред в государствах с разными политическими режимами может рассматриваться очень по-разному.

Всероссийский фестиваль технических достижений «Техносреда» на ВДНХ в Москве. Фото: Артем Геодакян / ТАСС

Три закона Азимова

И это уже всерьез поставило вопрос о том, что надо как-то искусственный интеллект регулировать. Собственно, эта проблема уже давно обсуждается в профессиональном сообществе. Одной из самых известных — и, надо сказать, продуманных — в этой области долгие десятилетия оставалась попытка фантаста и ученого Айзека Азимова в 1942 году (понятия ИИ тогда еще не было) сформулировать «три закона робототехники» с добавлением к ним в 1986 году еще одного, названного «нулевым».

0. РОБОТ НЕ МОЖЕТ ПРИЧИНИТЬ ВРЕД ЧЕЛОВЕЧЕСТВУ ИЛИ СВОИМ БЕЗДЕЙСТВИЕМ ДОПУСТИТЬ, ЧТОБЫ ЧЕЛОВЕЧЕСТВУ БЫЛ ПРИЧИНЕН ВРЕД.

1. РОБОТ НЕ МОЖЕТ ПРИЧИНИТЬ ВРЕД ЧЕЛОВЕКУ ИЛИ СВОИМ БЕЗДЕЙСТВИЕМ ДОПУСТИТЬ, ЧТОБЫ ЧЕЛОВЕКУ БЫЛ ПРИЧИНЕН ВРЕД.

2. РОБОТ ДОЛЖЕН ПОВИНОВАТЬСЯ ВСЕМ ПРИКАЗАМ, КОТОРЫЕ ДАЕТ ЧЕЛОВЕК, КРОМЕ ТЕХ СЛУЧАЕВ, КОГДА ЭТИ ПРИКАЗЫ ПРОТИВОРЕЧАТ ПЕРВОМУ ЗАКОНУ.

3. РОБОТ ДОЛЖЕН ЗАБОТИТЬСЯ О СВОЕЙ БЕЗОПАСНОСТИ В ТОЙ МЕРЕ, В КОТОРОЙ ЭТО НЕ ПРОТИВОРЕЧИТ ПЕРВОМУ ИЛИ ВТОРОМУ ЗАКОНАМ.

При всей своей всеобщности эти законы, конечно, не могли удовлетворить реальную регуляторику. Для нее долгое время самыми главными были два направления, имевшие очень четкое прикладное значение. Первое из них — это ответственность, наступающая в том случае, когда искусственным интеллектом были приняты решения, которые влекут за собой тот или иной ущерб. Виноват ли тут создатель ИИ, его владелец или еще кто-то? Ну и каким образом принимать сами эти решения: например, что должен делать беспилотный автомобиль в случае гипотетического выбора между спасением жизни своих пассажиров ценой жизни других людей, или наоборот?

Вокруг последней проблемы, известной также как «проблема вагонетки», возникло большое число обсуждений, научных и псевдонаучных работ, но все оставалось в основном в рамках теоретизирования. А вот с ответственностью там, где до этого дошло, стали применять принципы, относящиеся к домашним животным, — довольно успешно отработанные со времен, когда гужевой транспорт был основой мира. Коротко говоря, за животным признается некоторая свобода воли, но при этом хозяин несет ответственность за него. И, соответственно, он должен компенсировать любой ущерб вслучае, если не докажет, что предпринял все разумные усилия для того, чтобы такого ущерба не было.

Второе большое направление было связано с вопросами приватности и безопасности, особенно обострившимися, когда наши города оказались напичканы камерами наблюдения, дающими возможность для анализа всего и вся. Есть, например, и смежные вопросы об анализе данных пользователей в социальных сетях. Тут в зависимости от традиций тех или иных стран и политических режимов начало возникать разделение от «запретить все анализировать» до «все должно быть прозрачно и доступно государству». Возникают и эксцессы, когда на основании ошибки искусственного интеллекта начинают преследовать ни в чем не виновного человека.

Скандалы, разразившиеся в связи с этим в 2020 году сразу в нескольких странах (включая Россию), заставили серьезнее отнестись к такой области, как этика искусственного интеллекта. Подлили масла в огонь и возникавшие ошибки с распознаванием людей различных рас — тем более что они пришлись на пик активности движения BLM. Ответом стало появление в разных странах различных документов, касающихся соблюдения многообразных этических правил при разработке и применении систем искусственного интеллекта. Важные в мировой системе стандартизации организации ISO (Международная организация стандартизации) и IEEE (Институт инженеров электротехники и электроники, США) начали процессы выработки стандартов, запустилось движение в таких международных организациях, как ООН и ОЭСР, возникло много страновых инициатив. И даже в России решили, что сейчас не время для раскачки, и приняли осенью 2021 года «Кодекс этики искусственного интеллекта», разработанный Альянсом в сфере искусственного интеллекта совместно с Аналитическим центром и Минэкономразвития. Но все эти документы носили скорее характер общих рекомендаций из разряда «за все хорошее, против всего плохого». Не говоря о том, что никакого реального пути обеспечения применения таких норм не возникало.

Международная конференция AI Journey в Москве. Фото: Михаил Метцель / ТАСС

Наиболее системно за дело взялась европейская бюрократия. После нескольких лет работы, на пике хайпа, вызванного ChatGPT, в начале декабря 2023 года Европарламент объявил, что достиг согласия по принципиальным вопросам регулирования ИИ, и осталось только облечь это в форму официального документа, известного как AI Act. Сами принципы уже опубликованы и, скорее всего, станут в некотором смысле модельными и для других стран — для кого-то оказавшись примером для повторения, а для кого-то и наоборот.

Если это свести к кратким формулам, то, согласно AI Act,

- будет ограничено использование систем биометрической идентификации (с исключением только для правоохранительных органов, и то с оговорками);

- запрещен социальный скоринг (оценка человека по его социальным характеристикам, определение его условной полезности для общества) и применение ИИ для манипулирования поведением или использования уязвимостей пользователей;

- на уровне ЕС будет создан специальный орган для регулирования ИИ. За всеми гражданами будет закреплено право обжаловать действия искусственного интеллекта и получать содержательные объяснения по тем или иным принятым решениям (что до сих пор является самым слабым местом для так называемого машинного обучения, развитие которого и обеспечило современные прорывные результаты). А обеспечивать исполнение призваны крупные оборотные штрафы (вплоть до 7%) для компаний, разрабатывающих и эксплуатирующих ИИ.

Имплементация правил окажется довольно жесткой. В течение полугода после принятия Акта предполагается запретить несколько классов систем, которые были признаны потенциально несущими слишком высокие риски и не поддающимися регулированию, которое бы позволило их снять. В их число вошли системы, которые довольно активно развиваются в России и Китае. Это все, что связано с различными социальными рейтингами, распознаванием эмоций на рабочих местах или в образовательных учреждениях, нецелевое извлечение изображений лиц людей из интернета или записей видеонаблюдения для создания баз данных для распознавания лиц. Например, в России на некоторые из таких систем делают ставки не только государственные мужи для обеспечения более высокого уровня контроля, но и бизнес — практически в каждом серьезном университете есть те или иные проекты, связанные с распознаванием эмоций на занятиях, а стартапов, эксплуатирующих такую идею, насчитываются, по крайней мере, десятки.

Беспилотный интеллект

Насколько удастся обеспечить адекватное правоприменение, пока неясно. И вообще — не остановят ли разнообразные ограничения и транзакционные издержки, вызываемые регулированием, развитие технологий? Здесь европейские парламентарии нашли не совсем стандартный вариант ответа. Вся строгость ограничений относится к тем моделям ИИ, которые являются проприетарными, то есть закрытыми в рамках действий тех или иных конкретных игроков рынка. Те же, кто занимается открытыми моделями — то есть такими, которые доступны всем желающим и имеют лицензию, позволяющую ее свободно использовать не только разработчикам, — имеют гораздо меньше ограничений.

С одной стороны, это обеспечивает большую прозрачность рынка и позволяет избегать его монополизации. С другой — возникает больше возможностей для контроля со стороны общества. А с третьей — два наиболее успешных и перспективных европейских стартапа в области искусственного интеллекта, французский Mistral и немецкий Aleph Alpha, основываются именно на такой opensource бизнес-модели. Поэтому они, выступая активными лоббистами такого послабления, боролись не только за пользу для человечества, но и за свои конкурентные позиции.

Некоторые важные моменты, про которые много говорится, остались за рамками этого подхода. Например, дипфейки — сгенерированные с помощью возможностей искусственного интеллекта фото-, видео-, аудиоматериалы, являющиеся подделками. Но это и сейчас покрывается уголовным правом, так что совершенно не обязательно тут выстраивать какое-то ситуативное регулирование, ставшее столь популярным в России. Остается открытым и вопрос использования ИИ вместо человека, например, в образовании, где в значительной мере используется презумпция человека как единственного достаточно эффективного интеллектуального агента.

Сгенерированное ChatGPT эссе или даже дипломная работа, как наглядно показал полгода назад один из дипломников РГГУ, неотличимы для комиссии от написанной человеком.

Студент Российского государственного гуманитарного университета Александр Жадан меньше чем за сутки написал диплом при помощи чат-бота ChatGPT. Фото: соцсети

Окончательно европейское регулирование ИИ, видимо, будет принято уже в первой половине этого года. Скорее всего, довольно быстро появятся подобные акты и в других странах. Очевидно, они будут в чем-то пересекаться, а в чем-то противоречить друг другу. Например, одной из самых сложных для согласованного регулирования проблем станет использование ИИ в сфере применения силы — как на уровне общественной безопасности, так и в военных целях. Уже сейчас Россия и Украина активно используют друг против друга беспилотники, в управлении которыми пока не в полном объеме, но довольно активно используются некоторые решения на базе искусственного интеллекта. Пока это не принятие роботом собственного решения о применении летального оружия, но уже не надо быть провидцем, чтобы увидеть перспективу и такого развития событий.

Глобальное проникновение технологий вынуждает выстраивать и глобальное регулирование работы с ИИ. А он вовлекается и в геополитические процессы. Значит, помимо странового регулирования должно возникнуть и надстрановое — что в текущих международных условиях пока выглядит скорее утопично. Международные организации работают довольно плохо, и непонятно, кто из них мог бы стать глобальным регулятором. В каком-то смысле задача становится сродни атомной энергии — с одной стороны, гигантские положительные перспективы для человечества, с другой — огромная опасность его самоуничтожения. Найти какой-то работающий подход в атомной области отчасти удалось, а теперь возникает вопрос: можно ли повторить этот опыт в сфере искусственного интеллекта?

сноска